邊緣AI芯片物聯網行業的驚人崛起

發布時間:2020-11-17

瀏覽次數:276

1. 簡介

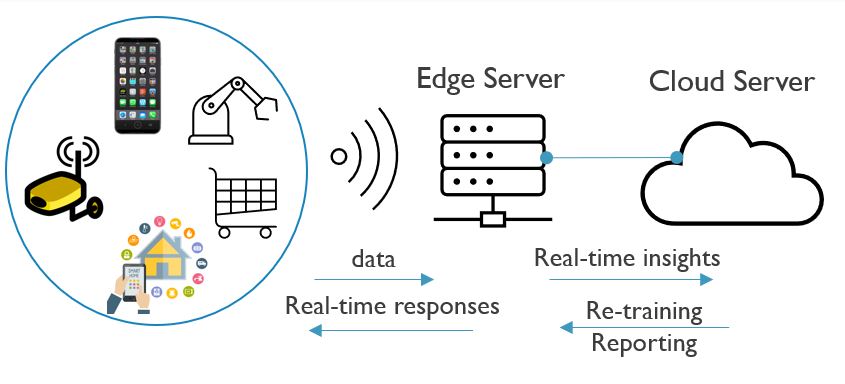

未來五年內,邊緣AI預計將以100%以上的速度增長,是芯片行業蕞大的趨勢之一。與基于云的AI相反,推理功能本地嵌入在位于網絡邊緣的物聯網(IoT)端點上,例如手機和智能揚聲器。物聯網設備與相對較近的邊緣服務器進行無線通信。該服務器決定將哪些數據發送到云服務器(通常,對時間不太敏感的任務(如重新培訓)所需的數據)以及在邊緣服務器上處理哪些數據。

圖1 邊緣AI芯片圖片

2. AI芯片現狀

與基于云的AI(數據需要從端點到云服務器來回移動)相比,邊緣AI更容易解決隱私問題(圖5)。它還具有響應速度快和減少云服務器工作負載的優勢。想象一下需要基于AI做出決策的自動駕駛汽車。由于需要快速做出決策,因此系統無法等待數據傳輸到服務器并返回。由于電池供電的IoT設備通常會施加功率限制,因此這些IoT設備中的推理引擎也需要非常節能。

圖2 邊緣AI框架

如今,使用快速GPU或ASIC進行計算的邊緣AI芯片(邊緣服務器內部的芯片)可提供每秒約1-100兆次運算/瓦(Tops / W)的效率,蕞高效率為每秒每瓦(Tops / W)。對于物聯網實施,將需要更高的效率。Imec的目標是證明推理效率為10.000 Tops / W。

3. 未來發展

通過研究模擬內存中計算架構,我們正在尋求一種不同的方法。這種方法打破了傳統的馮·諾依曼(Von Neumann)計算范式,后者基于將數據從內存發送到CPU(或GPU)進行計算。使用內存中模擬計算,可以在內存框架內完成計算,從而節省了來回移動數據的大量功能。在2019年,我們展示了一個基于SRAM的模擬內存計算單元(內置22nm FD-SOI技術),可實現1000Tops / W的效率。為了將這個數字進一步提高到10.000Tops / W,我們正在研究非易失性存儲器,例如SOT-MRAM,FeFET和基于IGZO的存儲器。

圖3 邊緣AI芯片應用場景

轉載請注明來源:ztcjxez.cn

滬公網安備 31011502016664號

滬公網安備 31011502016664號

唐女士-華南、西南

唐女士-華南、西南